はじめに

この記事はOllamaでよく使うコマンドの備忘録

実行環境

MacBook Air

M3チップ

メモリ16GB

Ollamaのインストール

Homebrew を使っているなら下記のコマンドを実行するだけ

brew install ollamaHomebrewを使っていない人は公式サイトから→https://ollama.com/download

コマンド

バージョンの確認

ollama -vollama version is 0.3.13ollamaが起動していないとWarningメッセージが出る

ヘルプの表示

ollama -h利用できるコマンド一覧が表示される

さらに、ollama [コマンド名] –help でそのコマンドの情報を表示できる

モデルの一覧

ollama lsインストール済みのリストが表示される

実行結果例

NAME ID SIZE MODIFIED

gemma2:latest ff02c3702f32 5.4 GB 3 days ago

dsasai/llama3-elyza-jp-8b:latest ecfdd92e89f6 4.9 GB 3 days ago

phi3:latest 4f2222927938 2.2 GB 8 weeks ago gemma2, llama3-elyza-jp-8b, phi3を過去にインストールしてあるため、このように表示された

モデルの実行

ollama run モデル名初めてのモデルはダウンロードが行われる(gemma2のときで2,3分ほどかかった記憶)

プロンプトを入力できるようになり、送信するとテキスト生成が行われる

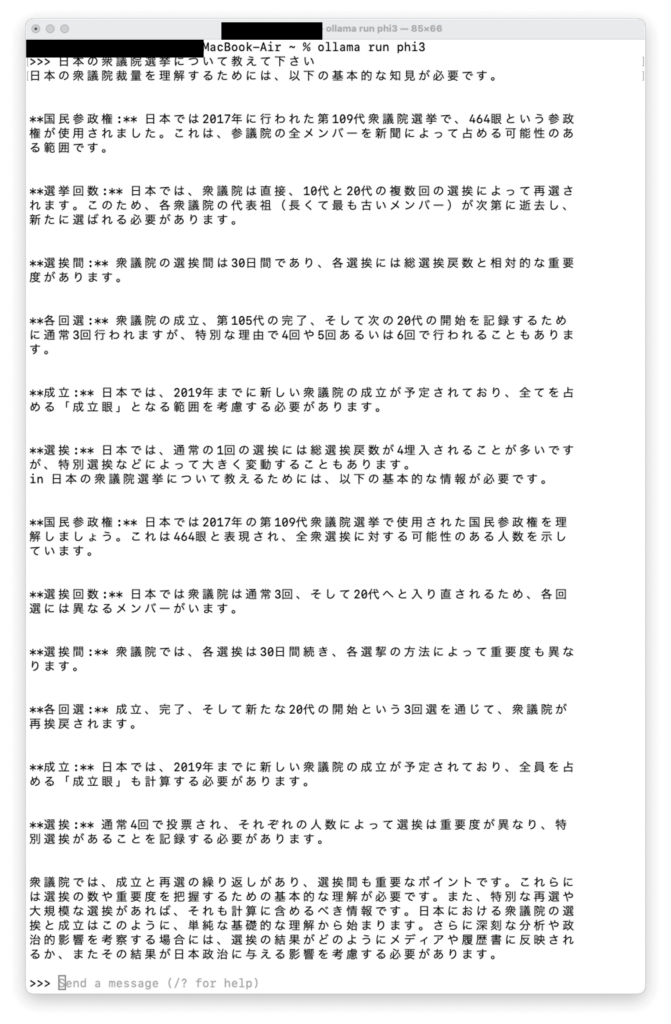

実行例(phi3)

意味不明な文章が返ってきた

/byeと入力すれば閉じることができる

モデル情報の表示

ollama show phi3実行結果

Model

architecture phi3

parameters 3.8B

context length 131072

embedding length 3072

quantization Q4_0

Parameters

stop "<|end|>"

stop "<|user|>"

stop "<|assistant|>"

License

Microsoft.

Copyright (c) Microsoft Corporation. おわりに

今回はollamaにあるモデルをダウンロードして実行することを行った。

API使用料を払わずに自分の環境で動かせることがローカルLLMの魅力。

今後やってみたいこと↓

バイナリ形式のggufファイルをダウンロードしてモデル化

pythonプログラムから呼び出して実行

コメントを残す